활성함수(Activation Function)는 인공신경망(Artificial Neural Network)에서 뉴런의 출력 값을 결정하는 비선형 함수입니다. 입력 신호를 받아 처리하고 출력값을 조정함으로써 모델의 학습 능력과 복잡한 문제 해결 능력을 제공합니다.

활성함수의 주요 역할

*비선형성 제공

- 선형 함수만 사용하면 뉴런의 조합도 선형으로 이어져 신경망의 깊이가 아무리 깊어도 복잡한 문제를 해결하지 못합니다.

- 활성함수는 비선형성을 추가해 복잡한 관계를 학습할 수 있도록 만듭니다.

*출력값 제한

활성함수는 출력값을 특정 범위로 제한하여 수치 안정성을 유지하고, 학습을 더 효율적으로 만듭니다.

*다양한 표현 학습

활성함수를 통해 신경망은 다양한 패턴을 학습하고, 이를 결합해 복잡한 문제를 해결합니다.

활성함수의 종류

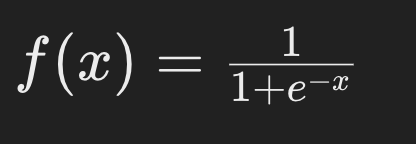

시그모이드(Sigmoid)

1. 정의:

2. 특징:

- 출력값이 00과 11사이로 제한됨.

- 확률 해석에 적합.

- 문제점: 기울기 소실 문제(Gradient Vanishing)가 발생할 수 있음

3. 사용 사례:

출력층에서 이진 분류 문제.

하이퍼볼릭 탄젠트(Tanh)

1. 정의:

2. 특징:

- 출력값이 −1-1과 11사이로 제한됨.

- 시그모이드보다 중심이 00에 가까워 학습 효율이 높음.

- 문제점: 기울기 소실 문제 여전히 존재.

3. 사용 사례:

중간층 활성함수로 사용되기도 함.

렐루(ReLU, Rectified Linear Unit)

1. 정의:

2. 특징:

- 계산이 간단하고 학습 속도가 빠름.

- 문제점: 음수 영역에서 뉴런이 죽는 문제(Dying ReLU)가 발생할 수 있음.

3. 사용 사례:

대부분의 신경망에서 기본 활성함수로 사용.

리키 렐루(Leaky ReLU)

1. 정의:

2. 특징:

- ReLU의 음수 영역 문제를 보완.

- α는 작은 양수로 설정.

3. 사용 사례:

ReLU의 대안으로 사용.

소프트맥스(Softmax)

1. 정의:

2. 특징:

- 출력값을 확률 분포로 변환.

- 모든 출력값의 합이 11이 되도록 함.

3. 사용 사례:

다중 클래스 분류 문제의 출력층.

활성함수 선택 가이드

출력층

이진 분류: Sigmoid

다중 클래스 분류: Softmax

은닉층

기본적으로 ReLU를 사용.

ReLU 문제 발생 시 Leaky ReLU나 Tanh 고려.

ETC.

- 활성함수의 선택은 모델의 학습 효율과 성능에 큰 영향을 미침.

- 특정 활성함수가 항상 최선은 아니므로 실험적 접근이 필요함.

'AI > 관련 자료' 카테고리의 다른 글

| [머신러닝] 미니 배치 경사 하강법(Mini-Batch Gradient Descent) 정리 (0) | 2024.11.21 |

|---|---|

| [머신러닝] 배치 하강 경사법(Batch Gradient Descent) 정리 (0) | 2024.11.20 |

| [머신러닝] 손실 함수(Loss Function)란? (0) | 2024.11.15 |

| [딥러닝] 원-핫 인코딩이란? / One-hot (0) | 2024.11.14 |

| [딥러닝] 텐서플로 케라스란? / TensorFlow Keras (0) | 2024.11.14 |